La herramienta de dialogo potenciada por IA ChatGPT de Open AI ha sido noticia desde su lanzamiento, hasta el punto de que se habla de competencia directa a Google y de predicciones sobre la muerte de la empresa de Mountain View. Sin embargo, todo esto forma parte de la evolución normal de las herramientas de búsqueda.

Desde hace unas semanas, la herramienta ChatGPT de Open AI es noticia por su sistema de preguntas y respuestas bastante impresionante (incluso en español), alimentado por inteligencia artificial. El sistema tiene sus límites, pero sigue siendo eficaz para una serie de consultas, sobre todo informacionales.

La IA de ChatGPT es asombrosa, pero comete errores y no está diseñada para corregirlos

La expectación sigue creciendo, ChatGPT, el motor de lenguaje dotado de OpenAI, ha sido la conversación de la web durante más de dos semanas. El efecto “wow” de los primeros días ha dado paso a una lectura más crítica. La IA se basa en algoritmos clásicos, y perfectibles.

¿Qué tiene ChatGPT en sus entrañas y qué podemos esperar razonablemente de él?

ChatGPT es impresionante. Pero detrás del efecto “wow”, encontramos de hecho algoritmos de aprendizaje automático bastante clásicos. ¿Se trata de un verdadero salto cualitativo, o es más bien una mejora incremental?

Para mí es un verdadero salto cualitativo. Por supuesto, las proezas de los algoritmos de aprendizaje profundo han recibido mucha publicidad en los últimos diez años. Que funcione bien no es ninguna sorpresa: estos métodos funcionan bien cuando hay suficientes datos para entrenar los modelos. ChatGPT se entrenó con un gran conjunto de datos formado por millones de páginas web.

Sin embargo, ChatGPT es capaz de generar textos largos, código informático con explicaciones, o incluso demostraciones matemáticas… Intenta plantearle la primera pregunta de un examen y seguro responde mejor que la mayoría.

ChatGPT no está especializado en un dominio de conocimiento concreto. ¿Podemos considerarlo como un asistente conversacional (chatbot), un asistente para hacer las tareas de la escuela, o incluso una amenaza para determinadas profesiones, como la redacción web?

ChatGPT ha “leído” más que cualquier humano, más que toda la humanidad en toda su vida, lo que explica sus performances. Pero no es sólo un “Super Google”, no se limita a escupir información en bruto. Tampoco es un chatbot en sentido estricto. Es otra cosa, diseñada para generar textos largos y maximizar su coherencia sintáctica.

Después, que hayamos dado un salto no significa que estemos en el fin del mundo. ChatGPT sigue siendo una IA, por lo que no va a crear nada realmente nuevo. En cuanto a si puede sustituir a determinados puestos de trabajo… Es, como mucho, un ayudante. Si quieres traducciones que realmente queden bien, tienes que pedirle a un traductor profesional que corrige despues de DeepL. Toda tecnología tiene un impacto en los puestos de trabajo, pero no me preocupa la desaparición de puestos cualificados, ChatGPT no va a sustituir a los SEO ni a los redactores web. Sobre todo, porque ChatGPT a veces comete errores, que no puede detectar, a diferencia de los humanos.

Pregunté a ChatGPT: “¿Qué ocurrió entre la Revolución Francesa y 1415? ” No pudo responderme, limitándose a señalar que la Revolución Francesa tuvo lugar después de 1415. Un humano habría podido responder de forma más creativa, más flexible, sin atascarse en el orden de los acontecimientos. Sobre todo, cuando ChatGPT comete errores, se ahogan en la masa. Esto es un tanto más problemático cuando da lugar a errores groseros más difíciles a identificar.

Ése es el problema: claro que los humanos cometemos errores, pero las IA también, ¡y lo olvidamos! La explicación es matemática: no podemos resolver un problema con certeza, a menos que dispongamos de un tiempo ilimitado. El Machine Learning es un cálculo aproximado. ChatGPT no es el Santo Grial que puede responder a todo: es inevitable que a veces haya errores con este tipo de IA.

ChatGPT no es capaz de saber cuándo se equivoca…

Las respuestas de ChatGPT son perentorias, desconoce la veracidad de lo que dice. De hecho, es un modelo muy determinista: si se le hace dos veces la misma pregunta, responderá dos veces lo mismo, a diferencia de un ser humano. Y si ha generado una respuesta que contiene un error, éste se propagará de una respuesta a otra durante la conversación, sin que la herramienta sea consciente de ello.

¿Por qué? Porque ChatGPT está diseñado para maximizar la coherencia de los términos que se suceden en las frases. No para minimizar el nivel de error. De hecho es un tema de investigación actual en este ámbito, toda la dificultad radica en medir este error. Para ChatGPT, la noción de error no existe.

ChatGPT evita las preguntas sobre emociones…

No se ha entrenado para eso. Podríamos imaginar textos que contengan elementos emocionales. Quizá algún día la inteligencia artificial tenga otros enfoques, en los que se trate de comprender la interacción social en su contexto. En otras palabras, comprender por qué el individuo está contento, triste, insatisfecho, y ver cómo podemos proponer una respuesta diferente. Hoy en día, no se trata de construir una inteligencia artificial capaz de simular todo el comportamiento emocional y social de los humanos. No estamos allí, y ése no es el objetivo.

Algunos analistas, como Lê Nguyên Hoang, del canal de YouTube Science4all, creen que ChatGPT nunca debería haberse ofrecido al público en general…

Es mostrando a las personas cosas que entienden. Cuando todos hayamos jugado con ChatGPT durante unas semanas, comprenderemos tanto sus proezas como sus limitaciones. Cuando los ingenieros diseñan un avión, ya no intentan reproducir un pájaro: lo que importa es la función. Y ChatGPT hace lo que se le pide: escribir frases coherentes, aunque a veces contesta fuera de lugar.

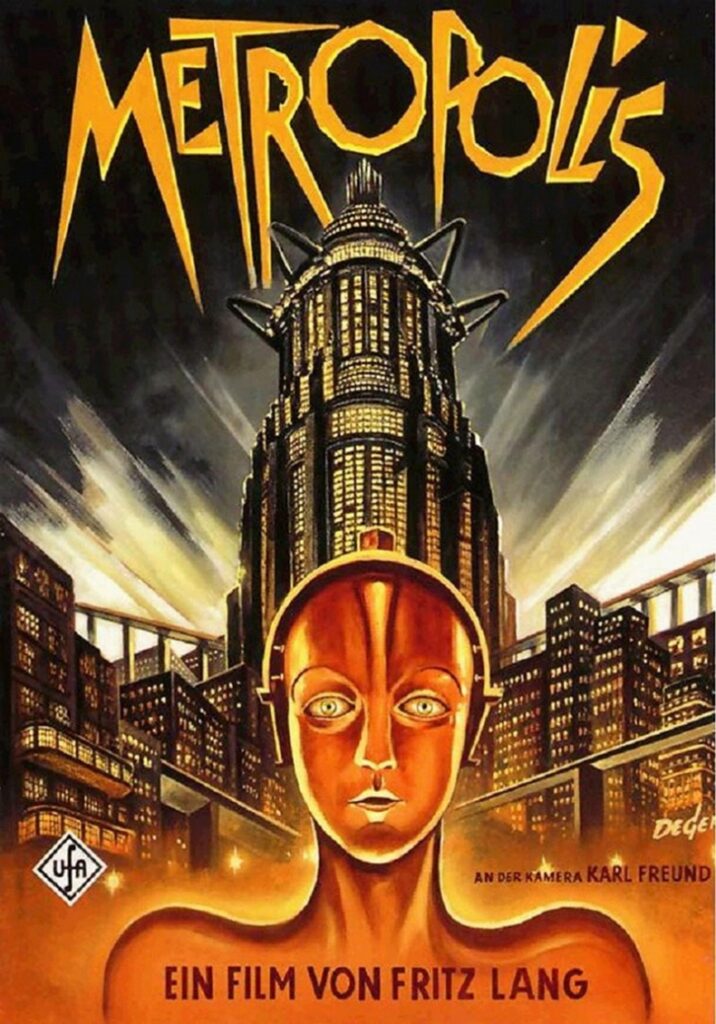

Hablamos del “Valle inquietante” para describir el hecho de que los robots humanoides con rasgos casi humanos nos perturban. Con ChatGPT, ¿estamos en el “valle inquietante” de la generación de textos?

Probablemente. Cuando se lanzó ChatGPT, estábamos en el efecto wow. Y dos semanas después, parece que estamos de nuevo en el valle inquietante. Pero no olvidemos que se trata de un fenómeno perceptivo, que depende del avance de la tecnología. Los robots humanoides de Fritz Lang en Metrópolis en 1927 parecían realistas a los espectadores de la época, pero esto ya no es así en absoluto hoy en día. Del mismo modo, dentro de unos meses, nuestra opinión sobre ChatGPT podría haber cambiado.

Vemos que esta herramienta apenas puede utilizarse sin comprobar el resultado obtenido en otras fuentes. Está claro que la fiabilidad no existe (todavía)… Haz una pregunta a ChatGPT sobre un tema que conozcas bien y te darás cuenta de inmediato. Hoy en día es inconcebible utilizar ChatGPT como un motor de búsqueda ordinario para tus necesidades lambda de búsqueda de información.

Sin embargo, la herramienta destaca por la forma de las respuestas que devuelve (frases estructuradas y largas, descriptivas, sin faltas de ortografía) y en esto es prometedor de lo que ocurrirá cuando se corrijan los numerosos errores actuales. Se puede estimar que el 90% del contenido de las respuestas proporcionadas es bastante fiable. Sin embargo, cuando el 10% de las respuestas son erróneas, esto no nos da una confianza inalterable en la herramienta. En este sentido, parece imposible que pueda competir con Google hoy en día. Por otra parte, es posible que refleje de forma evidente cómo serán los motores de búsqueda dentro de unos años.

Alerta roja en Google

El lanzamiento de este producto ha provocado un “código rojo” en Google, y los ejecutivos de la empresa de Mountain View parecen haber pedido a sus ingenieros que trabajen doble con el desarrollo (en marcha, por supuesto, desde hace muchos meses, sobre todo en torno a LaMDA) de una tecnología equivalente.

Pero está claro que las dimensiones del funcionamiento real entre ChatGPT y Google no son las mismas:

- El grado de errores que devuelve ChatGPT hoy en día no se aceptaría si fuera Google quien los devolviera en su motor oficial (pero puede que así sea en una herramienta experimental que seguramente se lanzará en 2023).

- El volumen de información acumulado e indexado por Google (cientos de miles de millones de páginas web) no tiene comparación con ChatGPT.

- Lo mismo ocurre con el volumen de búsquedas procesadas cada segundo.

Sundar Pichai, CEO de Google, y Jeff Dean, responsable de IA en Alphabet, adoptan una actitud prudente: “Se trata de un área en la que tenemos que ser audaces y responsables. Así que tenemos que encontrar un equilibrio (…) Para la investigación, las cuestiones de veracidad son realmente importantes; y para otras aplicaciones, las cuestiones de sesgo, toxicidad y seguridad también son primordiales.” Sam Altman, director general de OpenAI, ya lo dijo y recientemente admitió las limitaciones de su herramienta: “ChatGPT es increíblemente limitado, pero lo suficientemente bueno en algunas áreas como para dar la engañosa impresión de ser genial. Sería un error confiar en ella para algo importante en este momento (…) queda mucho trabajo por hacer en términos de robustez y veracidad.”

Así que, sin duda, deberíamos mirar más allá del aspecto “wow” (que es claramente real) de ChatGPT y decirnos que se trata sobre todo de una visión de lo que serán los motores de búsqueda a medio plazo (sabiendo que en Internet, la noción de medio plazo es relativa: estamos hablando aquí de sólo unos pocos años). Está claro que los “10 enlaces azules” desaparecerán pronto, al menos en su forma actual. Es probable que 2023 sea un año crucial en este sentido y que Google nos muestre cosas pronto, quizá ya en el evento Google I/O del próximo mes de mayo.

Queda por ver cómo se adaptará el SEO a esta nueva norma, a estos nuevos estándares de evolución. Porque es probable que la adaptación sea importante y no tan fácil… Pero ChatGPT aún está lejos de competir con el motor líder…