Google, a través de su portavoz Gary Illyes, lo había dicho en 2015, y lo ha repetido recientemente: la Web genera un 60% de contenido duplicado. Pero hay que analizar esta enorme estadística…

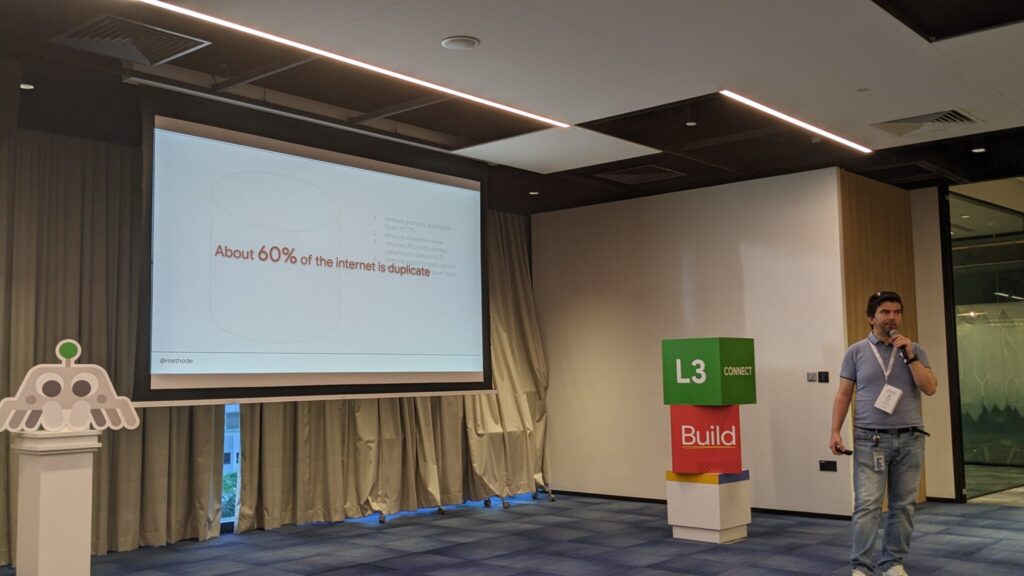

Google ya lo dijo en 2015, y Gary Illyes (que ya era la fuente de la información hace 7 años) lo repitió en un evento “Google Search Central Live” en Singapur hace poco: el 60% de la Web corresponde a contenido duplicado.

Según Kenichi Suzuki, que asistió a la conferencia de Gary y tuiteó las ilustraciones que aparecen a continuación, esta enorme cifra también corresponde a las URL:

- Duplicado HTTP/HTTPS ;

- Duplicados con o sin www ;

- Duplicidades debidas a parámetros innecesarios, como los identificadores de sesión;

- Duplicados debido a la presencia o ausencia de un slash al final;

- Duplicados debidos a checksums demasiado cercanos (ver las tipologías, algoritmos y métodos de optimización del contenido duplicado);

- Etc.

El contenido duplicado no es sólo un fenómeno que afecta al contenido editorial…

Podemos ver cuánto contenido duplicado genera la Web por defecto analizando el número de URLs rechazadas para su indexación en la Search Console de un sitio. ¡El número es a veces enorme!